研究紹介

強化学習と模倣学習の融合による人間らしいエージェント

強化学習によるエージェントは,環境と対話しているうちに試行錯誤を重ねて学習し,様々な課題が解決できる.例えば,囲碁や自動運転,テレビゲームなどがあげられる.しかしながら,強化学習エージェントは収益を最大化するように訓練されるため高い性能を示すが,実用化する際には,このような性能指標以外のことも考慮する必要がある.例えば,テレビゲームにおけるNPCを強化学習エージェントにすると,そのエージェントが強すぎるため,プレイヤーがゲームをあまり楽しむことができない可能性がある.また,自動運転に応用する際には,高い性能を目指して訓練された強化学習エージェントは,激しく加減速したり急に曲がったりして,隣接する車や歩行者などに不安を与える恐れがある.そこで,人間らしいエージェントを設計する必要がある.

- Rousslan Fernand Julien Dossa, Xinyu Lian, Hirokazu Nomoto, Takashi Matsubara, and Kuniaki Uehara, “Hybrid of Reinforcement and Imitation Learning for Human-Like Agents,” IEICE Transactions on Information and Systems, vol. E103.D, no. 9, pp. 1960-1970, 2020. (link)

- Rousslan Fernand Julien Dossa, Xinyu Lian, Hirokazu Nomoto, Takashi Matsubara, and Kuniaki Uehara, “A Human-Like Agent Based on a Hybrid of Reinforcement and Imitation Learning,” Proc. of The 2019 International Joint Conference on Neural Networks (IJCNN2019), Budapest, Jul. 2019. (link)

一方で,模倣学習では,人間エキスパートに提供されるデータ上でエージェントにそのエキスパートの方策を学習させるため,人間らしい態度が期待できる.ただし,学習される方策は提供されたデータに制限され,模倣学習エージェントの性能はエキスパートの性能を越えることができない.

それに応じて,強化学習の高い性能を保ったまま人間らしいエージェントを設計するため,強化学習と模倣学習の融合モデルを提案する.提案した融合モデルは強化学習の高い性能と人間のような振る舞いを示した.実験として,離散行動空間のケースとしてAtariゲームに適用した.さらに,自動運転のような実社会にも応用可能であることを実証するために,連続行動空間のTorcsという運転シミュレータで実験を行った.評価のため,性能評価と感性試験を行い,提案モデルが人間の模倣エージェントより高い性能を示し,強化学習エージェントより人間らしく振る舞うことを実証した.

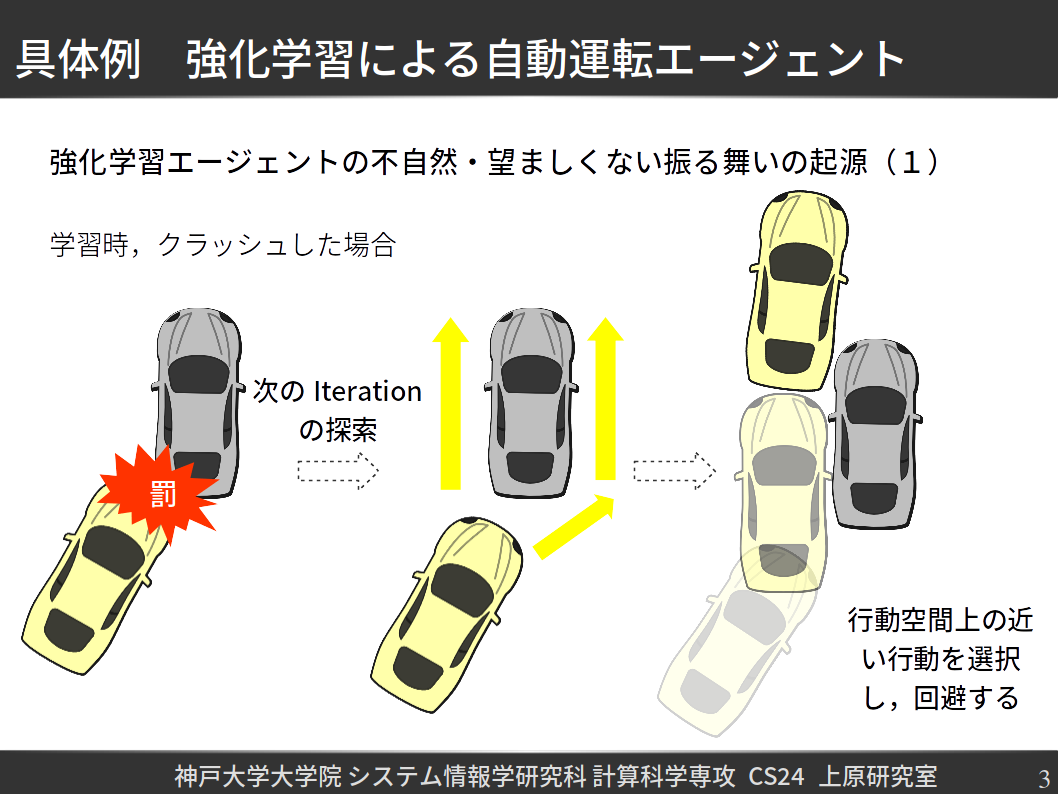

本研究の動機を,強化学習による自動運転エージェントの実現を踏まえて紹介す.エージェントは学習してるT時は,走行を促進した報酬関数以外は,障害物や他の車と衝突しないように罰が与えられている.以下の図のように,エージェントが他の自動車と数回衝突すると罰を受けるため,次に他の自動車の近傍にあれば,過去で選択した行動を摂動することで,回避の方策が学習できる.

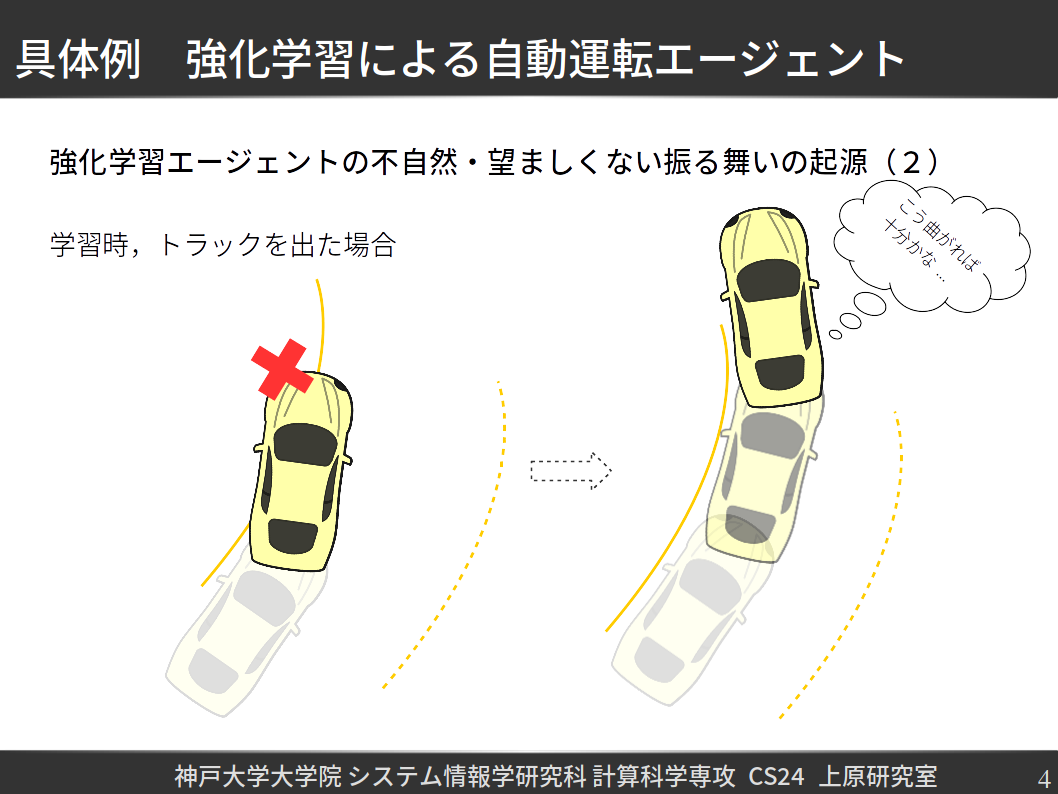

また,コースから出ないようにも罰が与えられており,上述の例と同じく,過去で選択した行動を摂動し,コースを出ずに走れるようになったら,そのままで最適な方策として学習される.

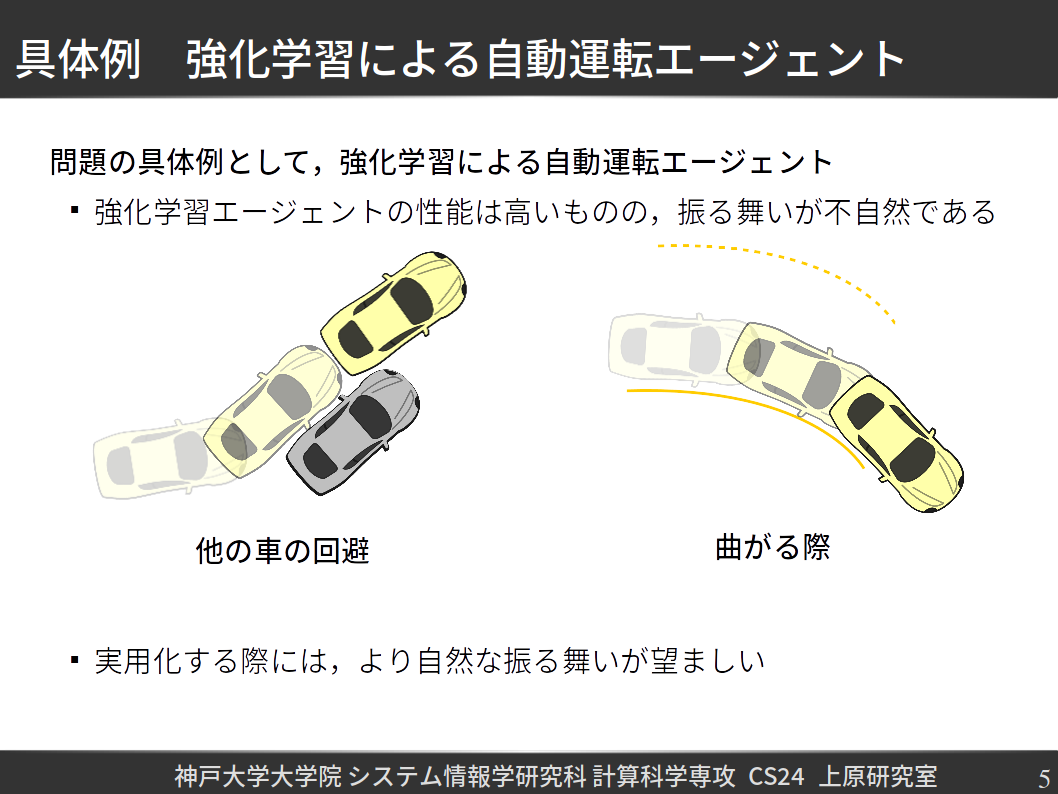

結果として,学習済みエージェントはコース全体を無事で走れるようになっても,障害物や他の車を回避する際には,危機一髪で回避を行ったり,さらにカーブのギリギリうちがわで曲がったりしている.実用化を考えると,やはりこのような振る舞いは他のユーザーに不安やけがをさせるというおそれがあり,より自然な,あるいは人間らしい振る舞いが望ましいと考えられる.

人間らしいエージェントを実現しようとしたら,最も単純な手法として模倣学習があげられる.模倣学習では,あるエキスパートに提供されたデータを参考にし,教師あり学習を行い,そのエキスパートを模倣したエージェントを訓練することができる.エキスパートを人間にした場合は,かなり自然な振る舞いを示したエージェントを訓練できるものの,そのエージェントの性能はエキスパートの性能に制限されることだけでなく,未知な状況(つまり,エキスパートのデモに入ってない)にうまく対応することができない.

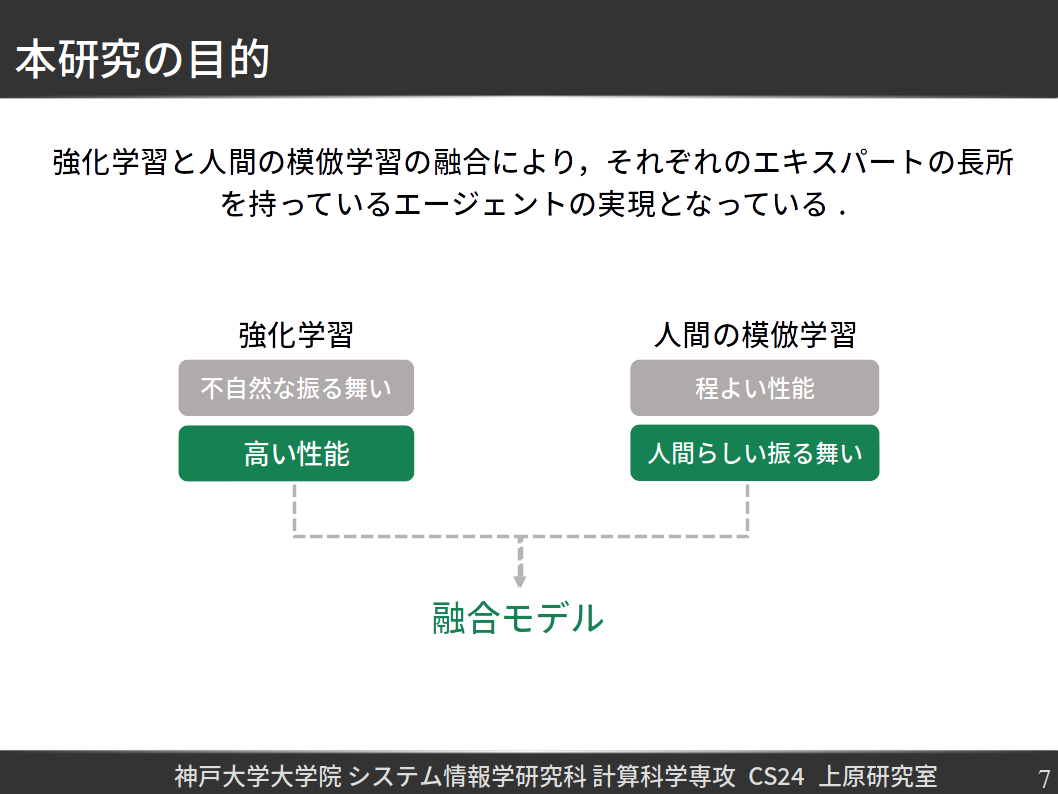

そこで,本研究は強化学習エージェントと人間の長所,すなわち強化学習の方から高性能と,人間の振る舞いによって安全性及び安心を保ったエージェントの実現になっている.

そこで,本研究は強化学習エージェントと人間の長所,すなわち強化学習の方から高性能と,人間の振る舞いによって安全次に,自動運転という課題に注目し,以下のスライドで問題設定を述べていく.

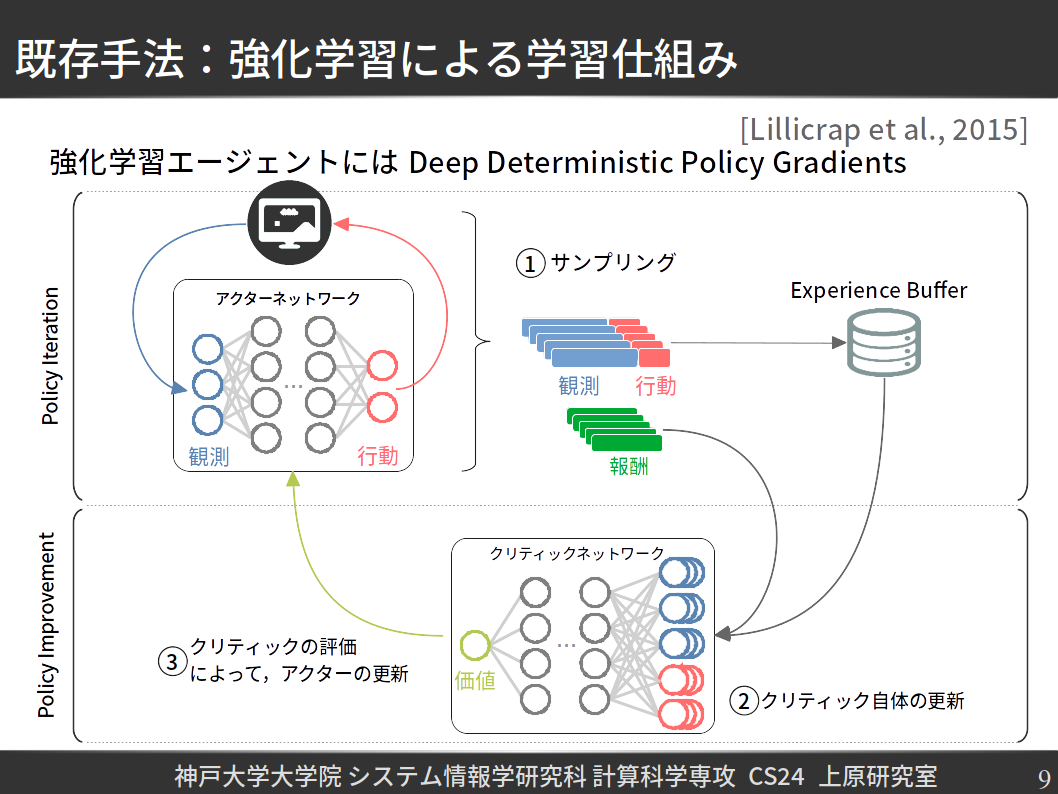

一般的なエージェントの学習仕組みは,Deep Deterministic Policy Gradients[Arxiv]といった強化学習手法を踏まえて紹介していく.

エージェントは基本的にActorとCriticという要素で構成されている.したがって,学習も二つのフェーズも分かれており,まずPolicy Iterationというフェーズでは,Actor Networkが環境と対話したり,様々な軌跡データをサンプリングし,Experience Bufferというもの(言い換えると,エージェントの記憶)に保存しておく.

二つ目のフェーズは,Policy Improvementと呼ばれ,まずExperience Bufferにある軌跡データを基に,Critic Networkの近似制度を最大化するように学習を行う.後者の出力は,Actorが任意な状態で選択した行動の価値として考えられるため,これからActorがより良い行動を選択するように勾配降下方を用いてActor Networkの重みを更新する.繰り返すと,最終的に,エージェントは最適な方策に収束する.

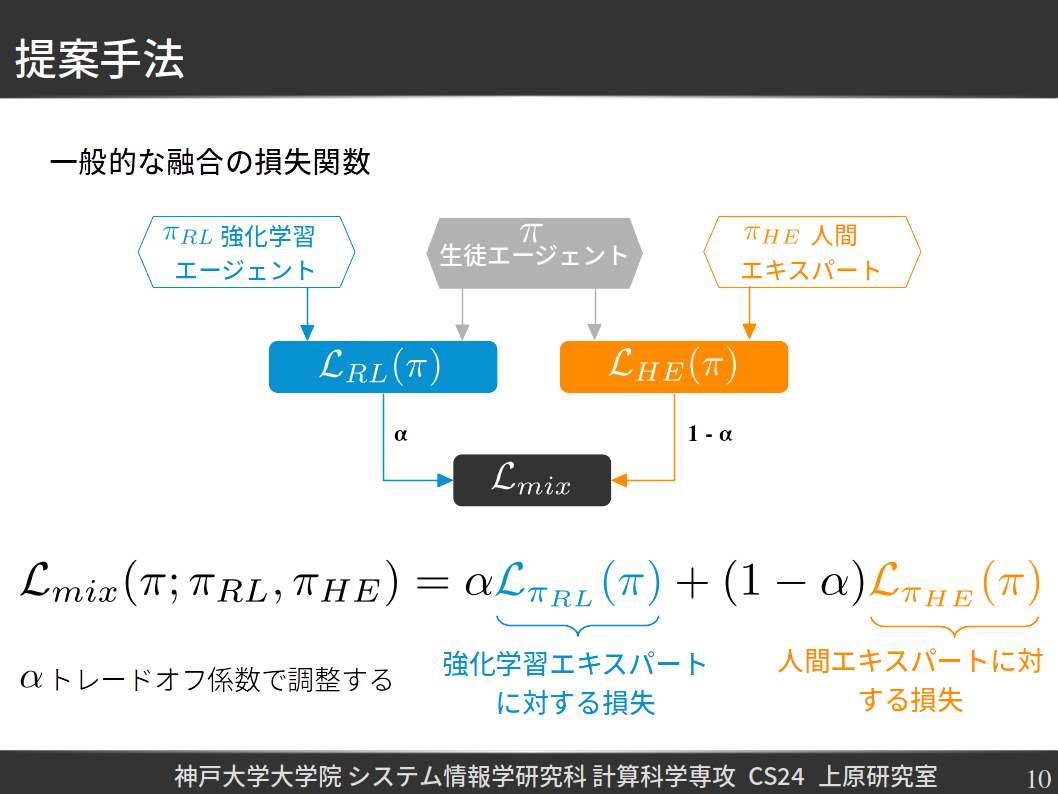

次に,どのように人間の振る舞いを考慮に入れるか紹介していく.まず,強化学習エージェントと人間エキスパートを融合するための一般的な損失関数を定義しておく.

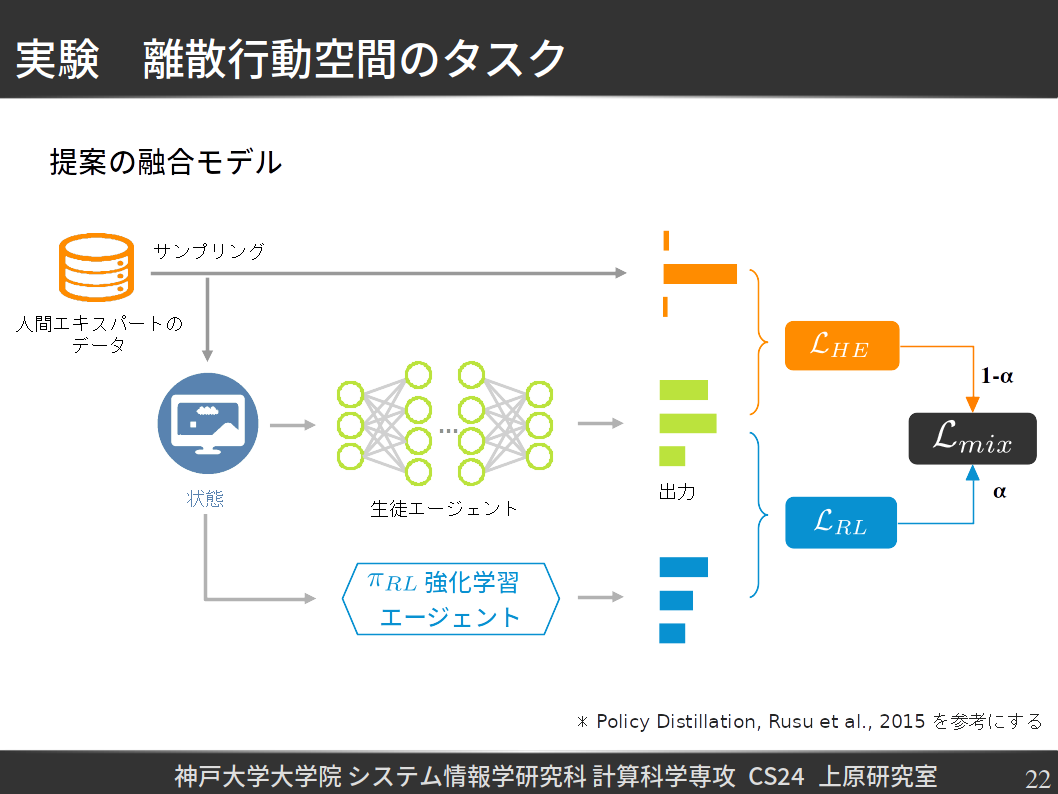

訓練済みの強化学習エージェントの方策と人間エキスパートの方策をPI_RLとPI_HEにした上で,それらの融合方策をゼロから学習していく生徒エージェントの方策をPIにしておく.次の段階では,それぞれのエキスパートに対するサをLoss_RLとLoss_HEとして表現し,最後に,それらをトレードオフ係数アルファーを用いて調整することは融合自体となっている.

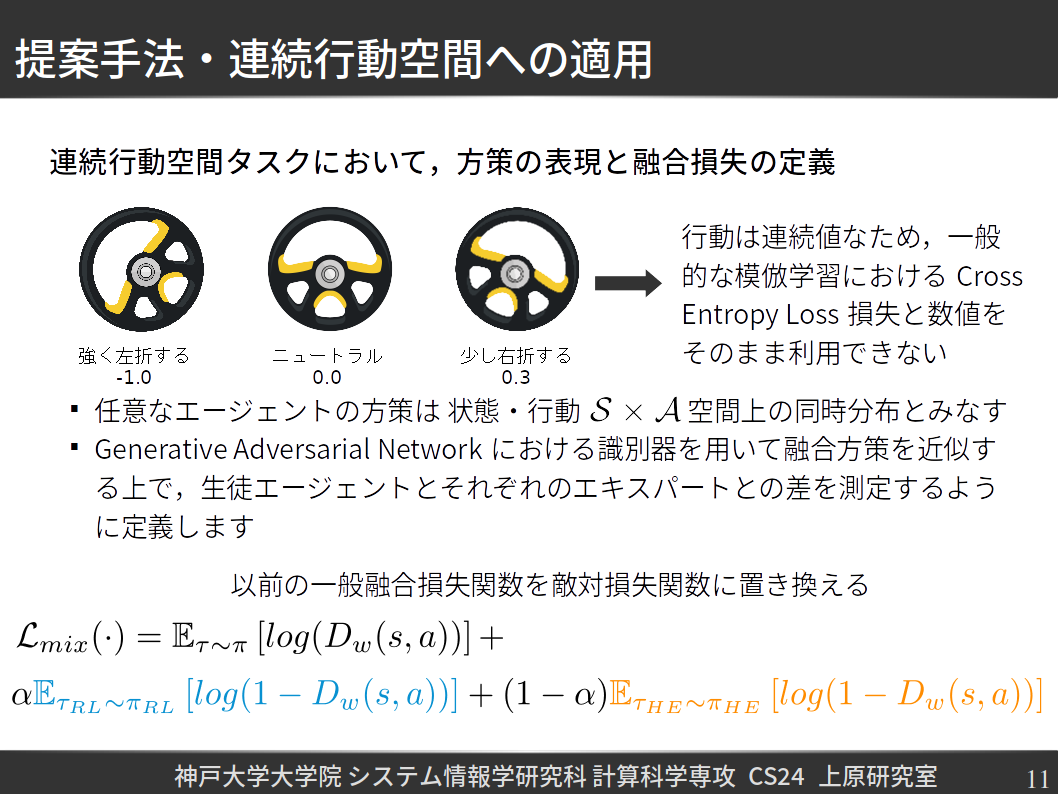

上述の融合方法は一般的であるため,次はどのようにTorcs Racing Car Simulatorのような連続行動空間タスクに適用するかを紹介していく.

まず,任意なエージェントの方策は,状態・行動空間上の同時確率分布とみあす.その上で,Generative Adversarial Networks[Arxiv]による識別器を活用し,生徒エージェントの方策とそれぞれのエキスパートの方策との差を測定し,融合方策も扱うことができる.

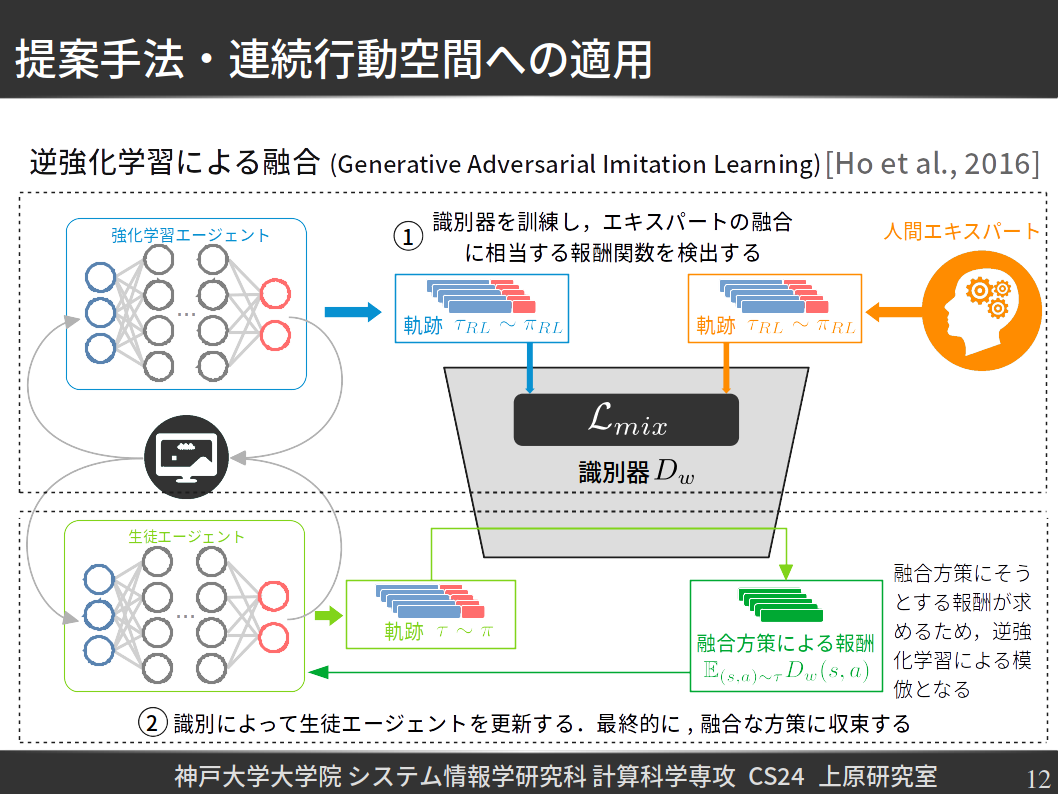

融合の流れもGenerative Adversarial Imitation Learningを基にし,二つのフェーズで構成されている.まず,一つ目のフェーズでは,強化学習エージェントと人間エキスパートの軌跡データを用いて,それらの融合方策を識別器が近似するように教師あり学習を行う.

二つめのフェーズでは,生徒エージェントの軌跡データを識別器に与え,融合方策とどれぐらい異なるかを測定した上で,環境自体からもらう報酬のかわりにする.さらに,以前に紹介された強化学習エージェントの一般的な学習仕組みによって生徒エージェントのネットワークの更新を行い,最終的にエキスパートらの融合方策に収束することが期待できる.

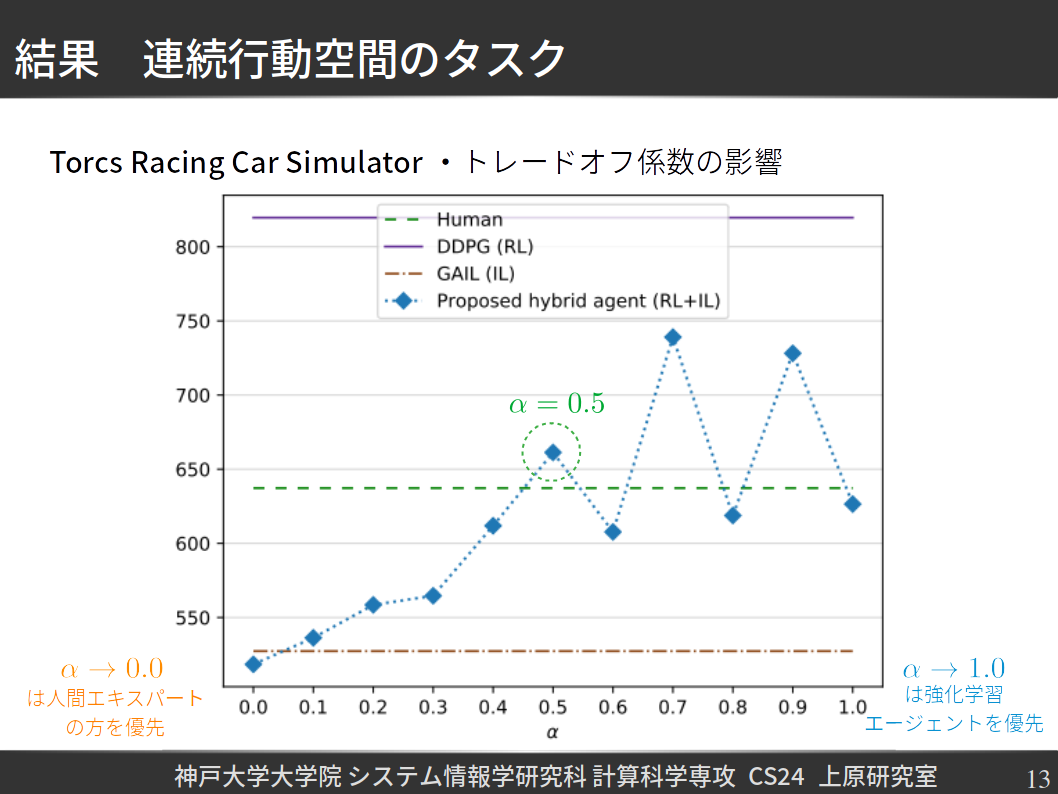

実験にあったては,初めにトレードオフ係数の影響を経験的に調べた.結果として,以下の図で示している通り,強化学習エージェントの影響があがるとともに,融合エージェントの性能も向上していき,人間エキスパートの性能を越えるようになっている.融合エージェントの代表として,アルファー=0.5に相当するエージェントにした上で,感性試験を行った.

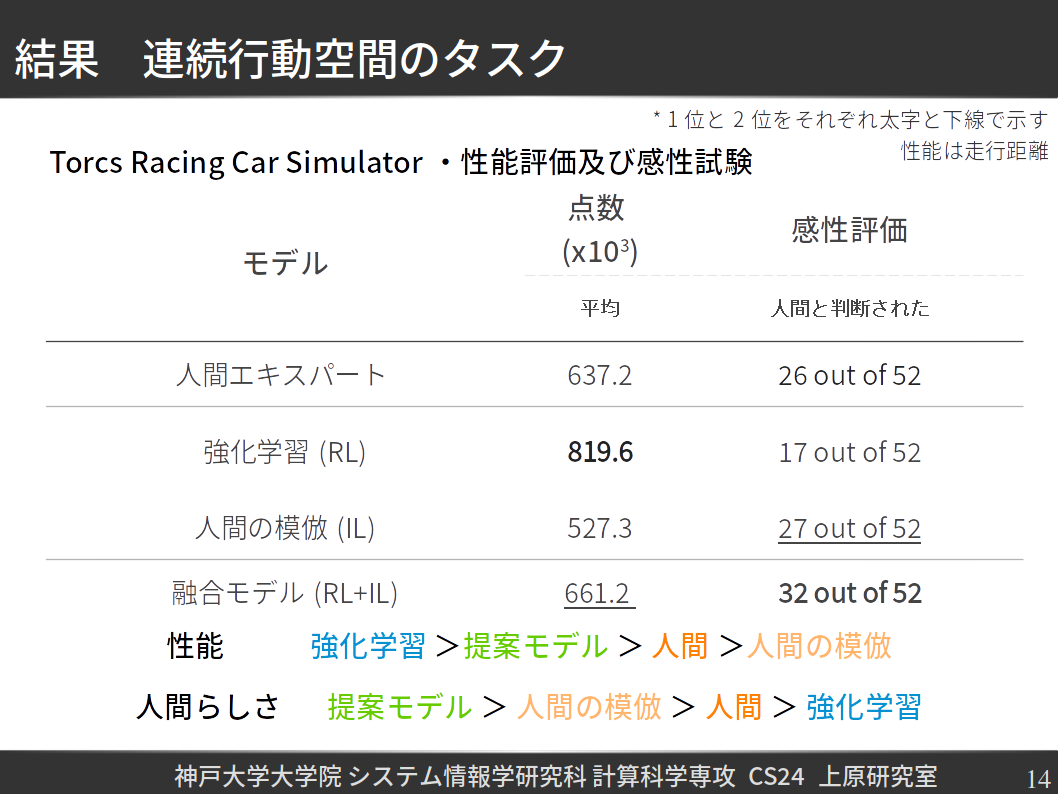

性能の観点からみると,提案手法による学習した融合エージェントの性能は人間エキスパート及びその模倣エージェントの性能を越えている.振る舞いの評価に関しまして,Turing Testのように,人間に感性試験をお受けいただき,その結果として,融合エージェントは,ただの強化学習エージェントより人間らしいと判断された.

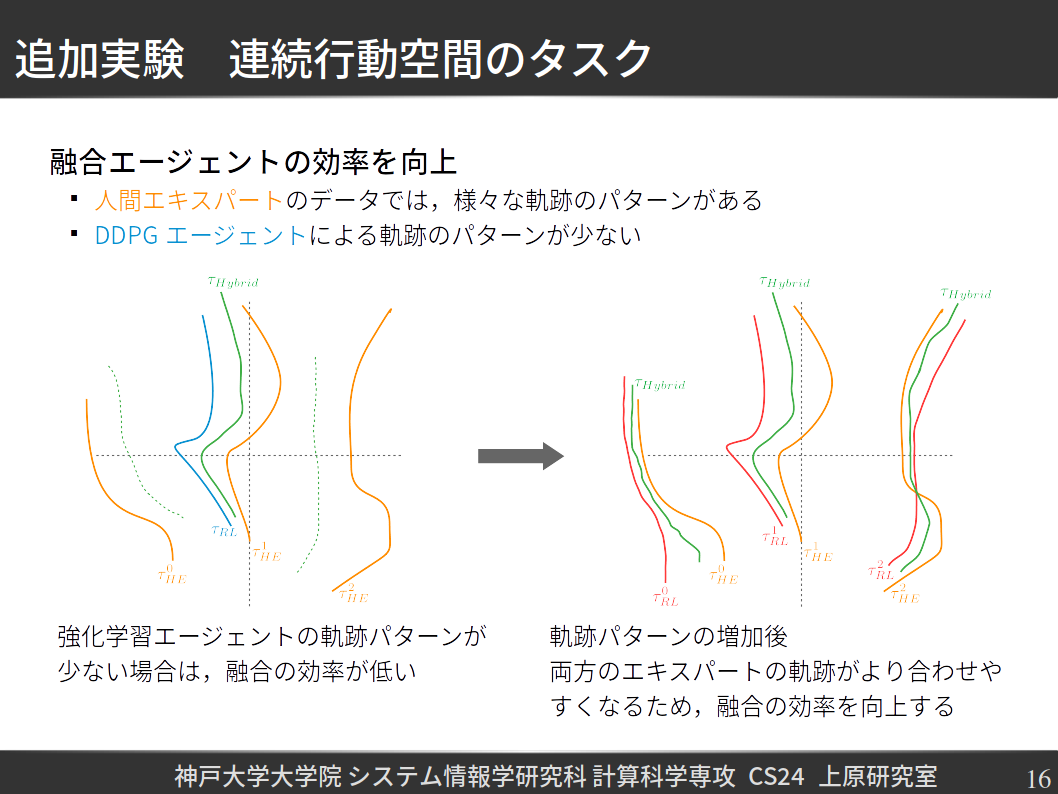

しかしながら,実験していたうちに,融合の効率にはまだ改善の余地があるという観察にたどりついた.なぜかというと,以下に右の図で示している通り,人間エキスパートの軌跡パターンが複数でありながら,これまで利用された強化学習手法は決定論的なため,相当するパターンが少ないと分かる.そこで,左の図で示しているように,強化学習エージェントの軌跡パターンを増加すれば,エキスパートらをより合わせやすくなり,融合自体の効率が向上できるのではないだろうかと仮説した.

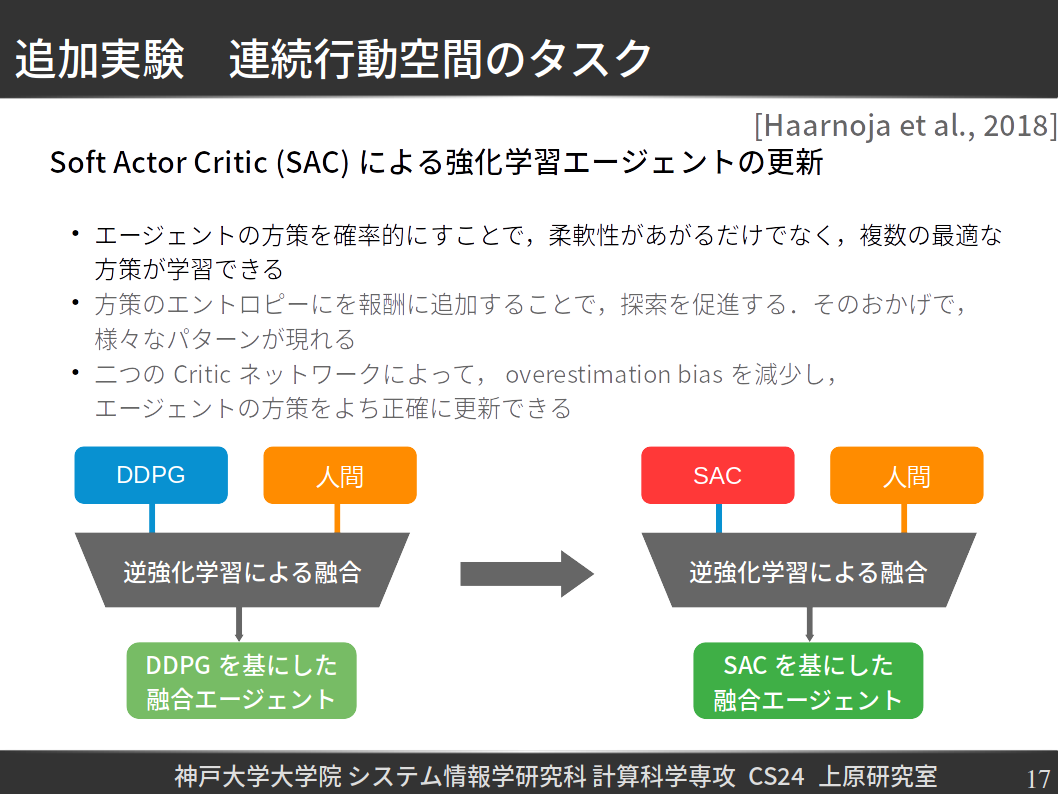

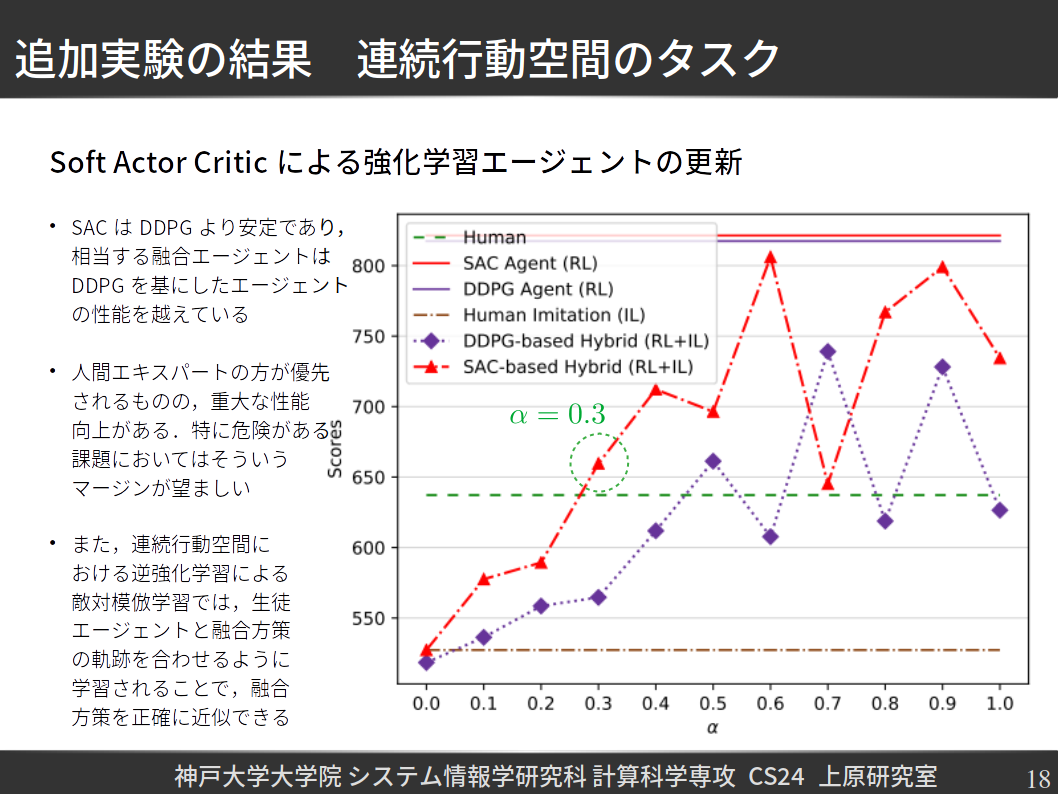

それに応じて,Soft Actor Critic[Arxiv]という強化学習手法を学習の仕組みに導入することを提案した.Soft Actor Criticでは,エージェントの方策が確率であるため,様々な最適な方策を同時に扱うことができるため,強化学習エージェンの軌跡パー単が増加すると考えられる.そして,Soft Actor Criticによって提案手法を更新した上で,更に融合実験を行った.

結果として,まずSoft Actor Criticを基にした融合エージェントの性能はDDPGを基にした融合エージェントの性能より高く,前者はより小さいトレードオフ係数を用いて(この場合はアルファー=0.3),後者の性能を満たしている.つまり,人間の方が優先されていても,性能の向上ができて,特に自動運転のような危険がある課題において,そいう余計がすごく大事で,望ましいと考えられる.

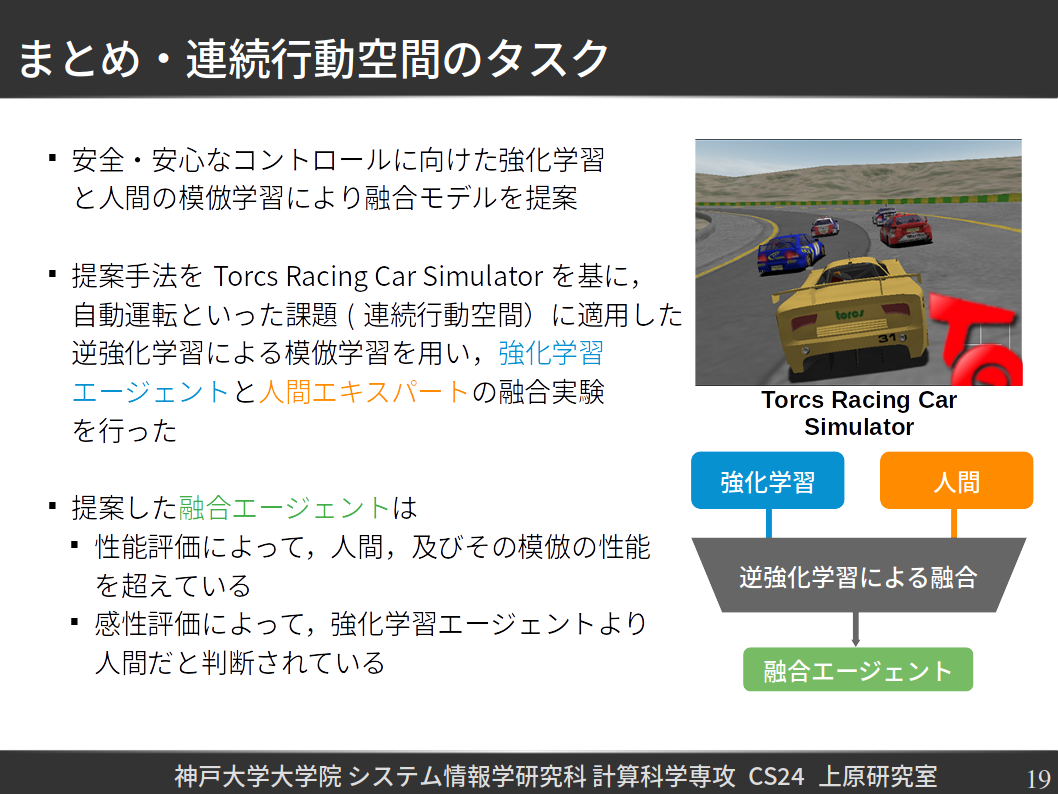

自動運転に関する実験が以上になり,以下にまとめる.

万全を期して,それぞれの強化学習エキスパートと融合エージェントのデモンストレーションも記載しておく

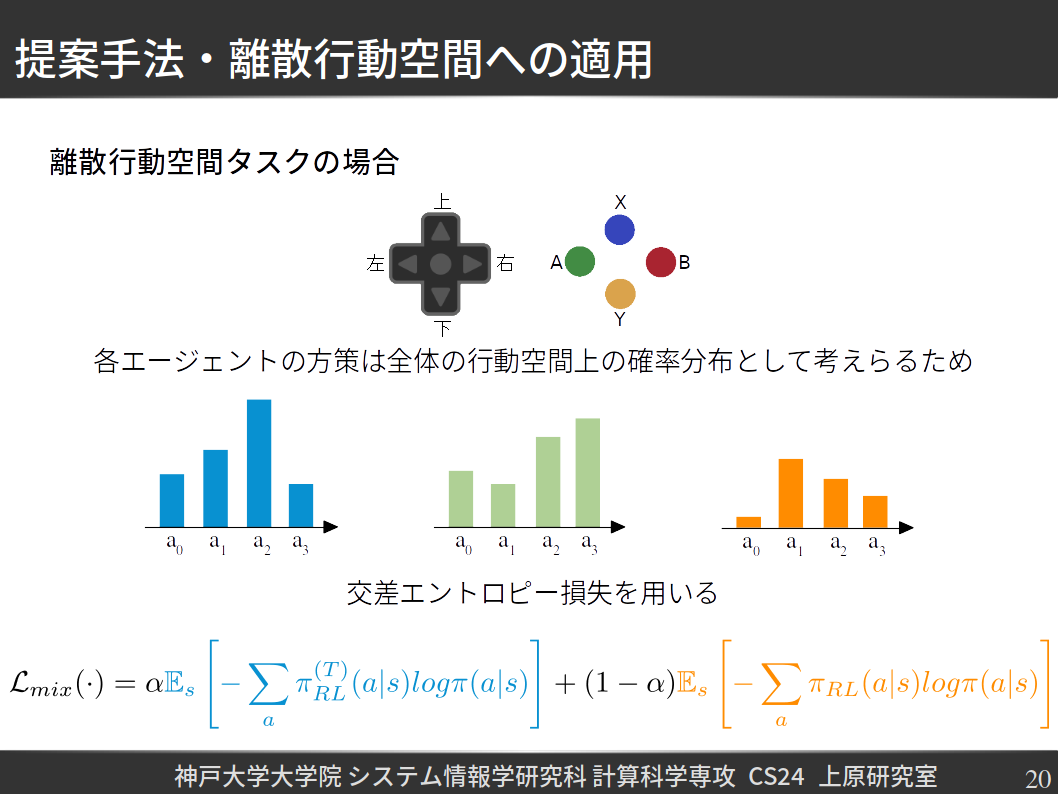

離散行動空間においては,エージェントの方策は,行動空間上の確率分布とみなす.媒介ロスを交差エントロピー損失関数を用いて求めることがでる.そこで,以前に紹介された一般的な融合損失関数は,下スライドに記述されている.

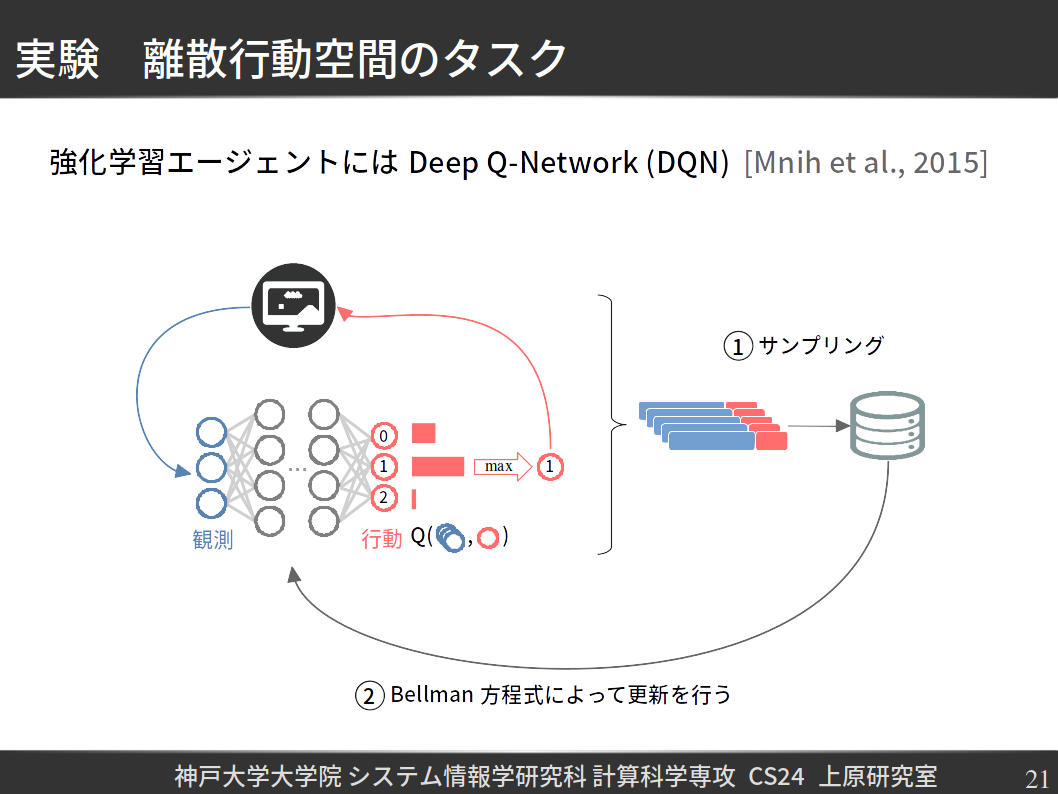

強化学習エージェントの実現には,Deep Q-Networks[Arxiv]といった強化学習手法を活用した.DQNによっては,エージェントがある状態にたいして,各行動の価値を推測してから,その価値を最大化する行動を選択し,環境で実効する.

そして,離散行動空間タスクおいては,Policy Distillation[Arxiv]を基にした融合方法を提案した.

学習時,人間エキスパートに提供されたデータから状態,及び観測データをサンプリングして,生徒エージェントにも,強化学習エージェントにも入力して,それぞれの行動が出力される.

生徒エージェントの行動と他のエキスパートの行動を基にして,融合損失を求められる.その損失を最小化するように生徒エージェントを学習させて,融合エージェントにる.

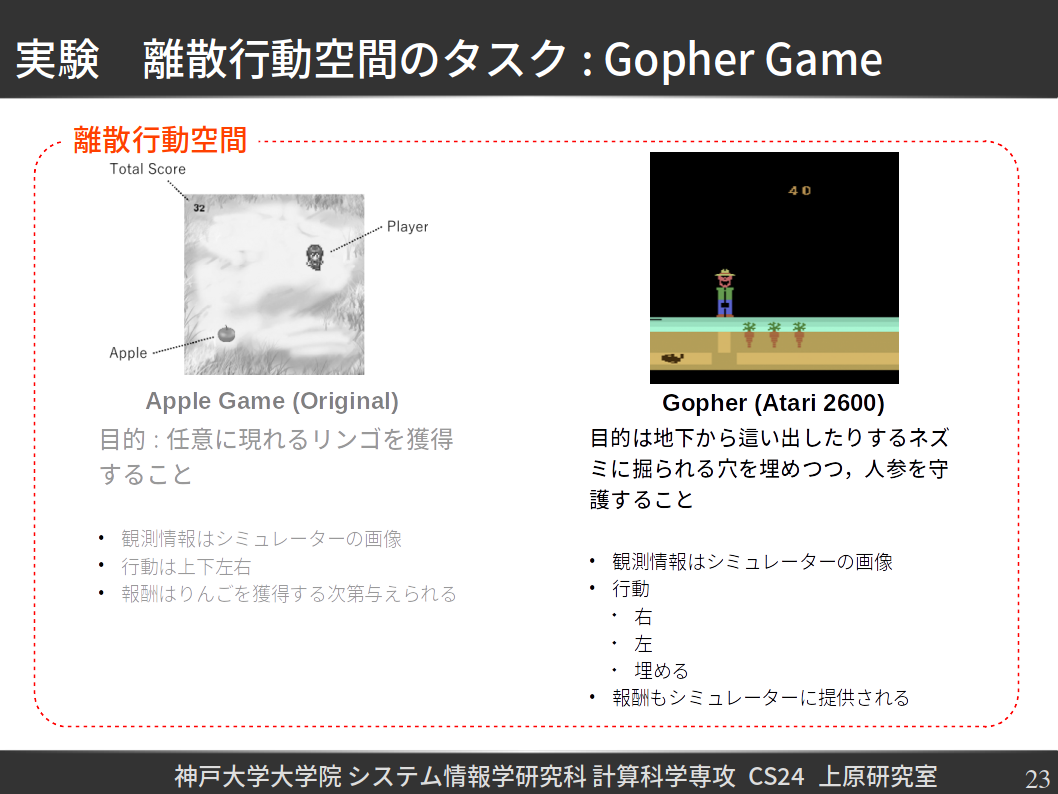

実験として,Atari 2600のGopherというゲームに提案手法を適用した.以下のスライドでは,ゲームの目的と条件なだが記載されている.

トレードオフ係数の影響に関しては,融合エージェントの性能が強化学習エキスパートの性能にも関わらず,人間エキスパート及びその模倣の性能と近いと分かる.最大な性能を達成したエージェントアルファー=1.0に相当するが,振る舞いが曖昧なため,トレードオフ係数アルファー=0.8のに相当するするエージェントを代表にした上で,感性試験も行って,結果は以下のようになる

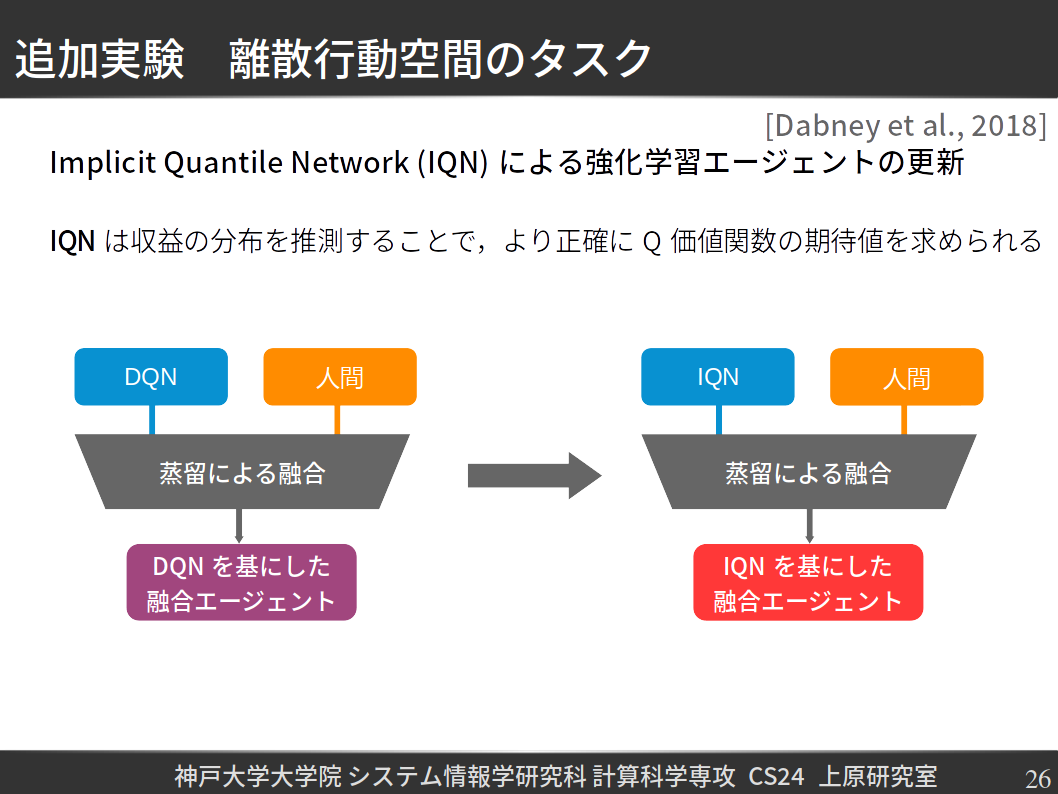

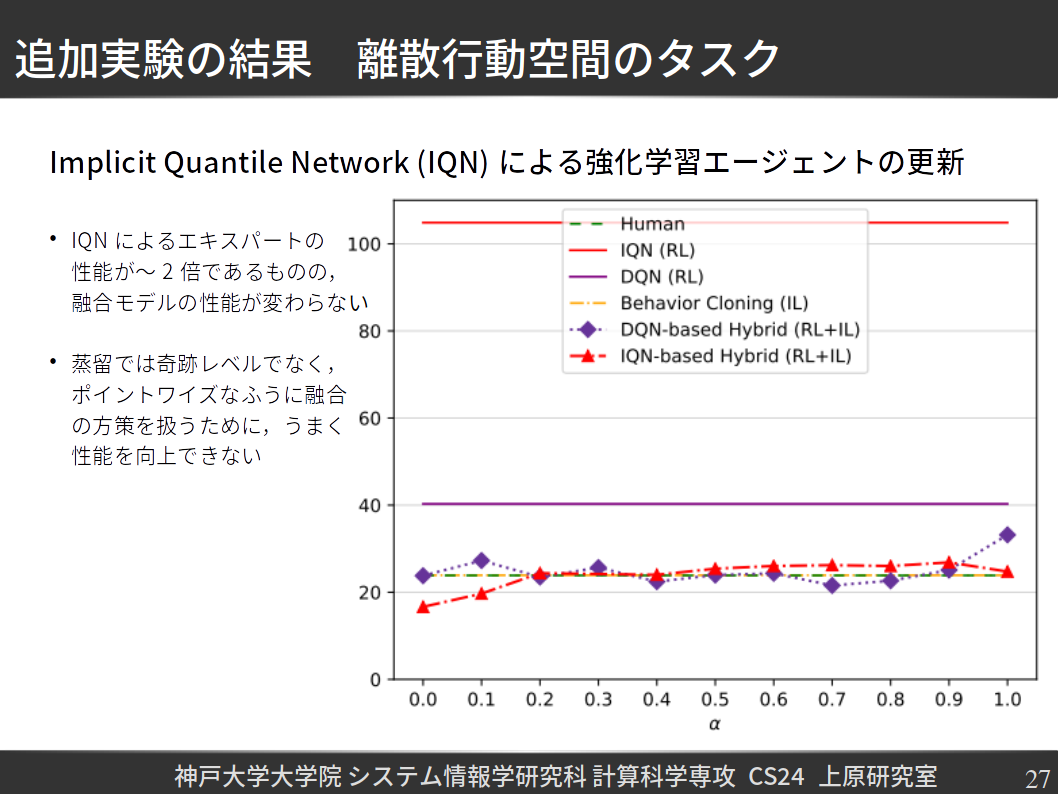

Torcs Racing Car Simulatorと同じく,DQNの代わりに,Implicit Quantile Network(IQN)[Arxiv]を活用し,融合エージェントの性能を向上するのではないだとうかと仮説した上で,融合実験を改めて行った.その結果として,IQNのエージェントの性能はDQNの数倍でありながら,融合モデルの性能はあまり変わらない.理由よして,蒸留による融合は正確に融合方策を扱うことができなく,強化学習エージェントの経験を活用できなくなる.

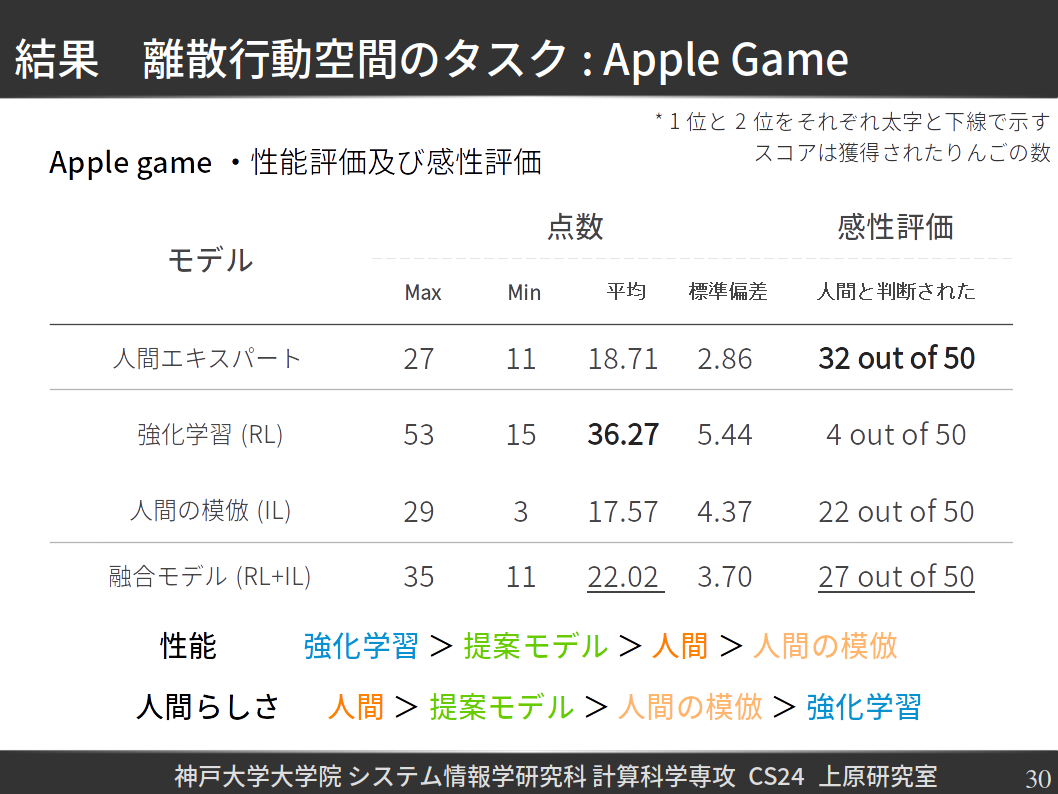

提案手法は初めに適用されたゲームはApple Gameであり,環境と実験の設定と結果は以下のようになっている.

この場合も,融合エージェントは人間エキスパート及びその模倣の性能を越えており,強化学習エージェントより人間らしいと判断された.